Sie erlernen einen umfassenden Einstieg in die Programmiersprache Python mit Fokus auf Data Science und Machine Learning. Nach dem Seminar sind sie fähig einfache Datenanalysen in Ihrem Unternehmen durchzuführen und ihre erworbende Kenntnisse selbständig zu vertiefen. U.a. folgende Python Pakete werden erläutert: pandas, numpy, matplotlib, seaborn, scikit-learn, statsmodels.

Big Data Analytics Seminar mit PySpark

Verarbeitung von großen Datenmengen mit Apache Spark und Python

Dieser praxisorientierte Kurs zeigt Ihnen wie Sie große Datenmengen (Big Data) mit PySpark (Python und Apache Spark) verarbeiten und analysieren können. Neben einer ausführlichen Einführung in PySpark wird die Integration von dem Python Datenanalyse Module Pandas in PySpark behandelt. Zudem werden die Möglichkeiten der Anwendung von Machine Learning in PySpark erläutert.

Dieser praxisorientierte Kurs zeigt Ihnen wie Sie große Datenmengen (Big Data) mit PySpark (Python und Apache Spark) verarbeiten und analysieren können. Neben einer ausführlichen Einführung in PySpark wird die Integration von dem Python Datenanalyse Module Pandas in PySpark behandelt. Zudem werden die Möglichkeiten der Anwendung von Machine Learning in PySpark erläutert.

| Termin (2 Tage)/ (4 Vormittage) |

Ort | Belegung | Preise | |

|

Mo 08.07 - Di 09.07.24 |

Live-Online Zoom Meeting |

|

1.290,00 € (*) 1.535,10 € (**) |

|

|

Do 14.11 - Fr 15.11.24 |

Live-Online Zoom Meeting |

|

1.290,00 € (*) 1.535,10 € (**) |

- Dauer: nach Absprache

- Termin: nach Absprache

- Angepasster Kurs zum Wunschtermin

- Bei Ihnen vor Ort oder Online

- Preis: nach Angebot

- Sprachen: Deutsch oder Englisch

Kurs auf einen Blick

Über die Schulung

- Dauer: 2 Tage

- Gruppengröße: 3-10

- Level: Anfänger mit grundlegenden Programmier- und SQL Kenntnisse

- Anteil Coding: 60%

- Sprache: Python

- Bibliotheken: pyspark, pandas, matplotlib

- Skript: .pdf (Theorie, Aufgaben & Lösungen)

Ihr Trainer für den Kurs

Schulung auf einen Blick

- Analyse großer Datenmengen

- Überblick zu Hadoopp und Kubernetes

- Spark als Datenverarbeitungsframework

- Einladen von Daten

- Datenaufbereitung (Transformation, Filtern, Joinen, Aggregation)

- Ausführungsmodelle von Apache Spark

- Datenorganisation in Big Data Projekten

- Integration vom Datascience Modul Pandas

- Maschinelles Lernen in PySpark

Beschreibung des Big Data Kurses

Der Kurs gliedert sich thematisch in drei Breiche, die die Teilnehmer schrittweise an Apache Spark heranführen.

Der erste (eher theoretische) Teil gibt einen knappen Überblick aktueller Technologien zur Speicherung und Verarbeitung großer Datenmengen (Hadoop und Kubernetes), und welchen Platz Spark als wichtiges Datenverarbeitungsframework darin einnimmt.

Der zweite, praktisch angelegte Teil umfasst eine ausführliche Einführung in die Arbeit mit Apache Spark mit Python (PySpark). Dieses Modul stellt den Kern des Workshops dar. Dementsprechend werden dabei alle wichtigen Punkte angesprochen:

• Einladen von Daten

• Datenaufbereitung (Transformation, Filtern, Joinen, Aggregation)

• Anbindung verschiedener Datenquellen

• Ausführungsmodelle von Apache Spark

• Integration von dem Python Data Science Module Pandas und wichtige Unterschiede

Die Teilnehmer werden all diese Schritte direkt an praktischen Beispielen und Übungen umsetzen. Zusätzlich werden auch gängige Grundkonzepte zur Datenorganisation in Big Data Projekten angesprochen.

Der dritte Teil behandelt schließlich die in Spark vorhandenen Möglichkeiten zur Datenanalyse und zum maschinellen Lernen (ML). Es werden kurz die grundlegenden Konzepte und Vorgehensweisen von ML erläutert und an einem Beispiel mit PySpark praktisch angewandt.

Der Kurs gliedert sich thematisch in drei Breiche, die die Teilnehmer schrittweise an Apache Spark heranführen.

Der erste (eher theoretische) Teil gibt einen knappen Überblick aktueller Technologien zur Speicherung und Verarbeitung großer Datenmengen (Hadoop und Kubernetes), und welchen Platz Spark als wichtiges Datenverarbeitungsframework darin einnimmt.

Der zweite, praktisch angelegte Teil umfasst eine ausführliche Einführung in die Arbeit mit Apache Spark mit Python (PySpark). Dieses Modul stellt den Kern des Workshops dar. Dementsprechend werden dabei alle wichtigen Punkte angesprochen:

• Einladen von Daten

• Datenaufbereitung (Transformation, Filtern, Joinen, Aggregation)

• Anbindung verschiedener Datenquellen

• Ausführungsmodelle von Apache Spark

• Integration von dem Python Data Science Module Pandas und wichtige Unterschiede

Die Teilnehmer werden all diese Schritte direkt an praktischen Beispielen und Übungen umsetzen. Zusätzlich werden auch gängige Grundkonzepte zur Datenorganisation in Big Data Projekten angesprochen.

Der dritte Teil behandelt schließlich die in Spark vorhandenen Möglichkeiten zur Datenanalyse und zum maschinellen Lernen (ML). Es werden kurz die grundlegenden Konzepte und Vorgehensweisen von ML erläutert und an einem Beispiel mit PySpark praktisch angewandt.

Was lernen Sie im PySpark Seminar?

Der Fokus des Workshops liegt auf dem Umgang mit PySpark zur Verarbeitung und Analyse großer Datenmengen. Der Bereich „Machine Learning“ wird im letzten Teil ebenfalls besprochen, jedoch wird das Thema aufgrund der inherenten Komplexität theoretisch nur knapp umrissen. Im Mittelpunkt steht vielmehr, welche Möglichkeiten Apache Spark zu diesem Anwendungsgebiet anbietet, und unter welchen Bedingungen der Einsatz von PySpark anderen Alternativen vorzuziehen ist.

Der Workshop versetzt die Teilnehmer in die Lage, selbständig Daten mit Hilfe von Apache Spark zu transformieren und analyieren.

Der Fokus des Workshops liegt auf dem Umgang mit PySpark zur Verarbeitung und Analyse großer Datenmengen. Der Bereich „Machine Learning“ wird im letzten Teil ebenfalls besprochen, jedoch wird das Thema aufgrund der inherenten Komplexität theoretisch nur knapp umrissen. Im Mittelpunkt steht vielmehr, welche Möglichkeiten Apache Spark zu diesem Anwendungsgebiet anbietet, und unter welchen Bedingungen der Einsatz von PySpark anderen Alternativen vorzuziehen ist.

Der Workshop versetzt die Teilnehmer in die Lage, selbständig Daten mit Hilfe von Apache Spark zu transformieren und analyieren.

Organisatorisches

- Vorstellungsrunde

- Erwartungen der Teilnehmer

- Kontext und Einordnung des Frameworks (Pyspark vs. Hadoop / Kubernetes)

- Grundlegende Konzepte der verteilten Datenverarbeitung mit Apache Spark

- Grundlagen von DataFrames

- Einladen von JSON und CSV Daten

- Einfache Transformationen (Projektionen, Filter, einfache Funktionen…)

- Gruppierte Aggregationen

- Sortieren

- Joins

- Effiziente Pandas UDF in PySpark

- Anwendungsgebiete

- Überblick über unterstützte Dateiformate

- Training & Modelle

- Regressionsmodelle

- Trainings- und Validierungsdaten

- Metriken zur Bewertung eines Modells

- Übung mit dem NYC Taxi Datensatz

- Formatkonvertierung zur Beschleunigung

- Integration verschiedener Datenquellen

- Erste einfache Datenanalysen und -visualisierungen

- Datenreduktion durch Aggregation

- Machine Learning mit PySpark

- Bewertung des Modells mit Hilfe passender Metriken

- Verbesserung durch neue Features

- Diskussion weiterer Ideen zur Verbesserung

Zielgruppe der Big Data Analytics Weiterbildung

Der Kurs wendet sich primär an Data Scientists und Data Analysts, die mit Hilfe von Python und Apache Spark (PySpark) große Datenmengen verarbeiten und analysieren möchten.

Voraussetzungen für das Big Data Analytics Seminar

Die Teilnehmer sollten grundlegende Programmier- und SQL Kenntnisse besitzen. Alle Programmierbeispiele für Apache Spark werden in Python umgesetzt. Die Erfahrung zeigt, dass sich Teilnehmer mit Kenntnissen in anderen Programmiersprachen schnell in Python zurechtfinden.

Englischkenntnisse (lediglich im Verstehen von englischen Texten) sind sehr nützlich, da Python und die Internet-Dokumentationen auf Englisch sind. Daher sind auch die Folien im Kurs auf Englisch. Die Schulung selbst wird auf Deutsch gehalten.

Didaktischer Aufbau des Big Data PySpark Kurs

Dieses Big Data Seminar ist sehr praxisorientiert. Die Konzepte werden in der Schulung mit Folien erläutert und an Beispielen verdeutlicht. In den Übungseinheiten der Schulung können die Teilnehmer mit der Programmiersprache Python in der Cloud mit Jupyter Notebooks das Erlernte umsetzen. Der Trainer unterstütz bei verschiedenen Aufgaben und begleitet bei Fragen.

Technik in der Big Data Analytics Weiterbildung

- Die Teilnehmer benötigen zur Teilnahme einen eigenen Rechner, auf dem ein aktueller Browser (Chrome, Firefox, Edge) zur Teilnahme an der Video-Schulung installiert ist. Entsprechend sollten die Teilnehmer auch über Mikrofon und Kopfhörer oder Lautsprecher verfügen. Eine Kamera für die Teilnehmer ist optional und freiwillig.

- Um ein möglichst realistisches Erlebnis zu ermöglichen, erhält jeder Teilnehmer ein eigenes kleines Cluster innerhalb der Amazon Cloud, der Zugriff erfolgt über SSH und den Web-Browser. Damit wird neben einem Web-Browser auch keine weitere Software auf den Computern der Teilnehmer benötigt.

- Bitte prüfen Sie, ob Ihr Firmenlaptop Zugangsbeschränkungen im Internet hat. Die digitalen Unterlagen (Skript) werden im Seminar online zum Download zur Verfügung gestellt. Sie erhalten vor dem Seminar per E-Mail den Link zu einer Testdatei zum Download, um dies überprüfen zu können.

- Sie sollten sich in firmenfremde WLAN-Netze registrieren können um Zugang zum Internet am Veranstaltungsort zu haben. Einige Teilnehmer können Sie sich alternativ auch über Ihr Firmen-Handy ins Internet einwählen (WLAN-Tethering / Hotspot).

- Als Backup Lösung ist es möglich, dass der USB Port bei Ihrem Laptop freigeschalten ist, um damit verwendete Dateien oder sonstige Unterlagen übertragen zu können.

Wir bieten den Kurs neben dem Live-Online Format auch in folgenden Städten an: Stuttgart, Ulm, Frankfurt, München, Hamburg, Berlin, Köln. Falls Sie die Schulung gerne in einer anderen Stadt oder direkt bei Ihnen im Unternehmen besuchen möchten, kontaktieren Sie uns gerne.

- für KMU und Einzelpersonen

- Übernahme von bis zu 500 EUR der Kursgebühren

Online ab 2 Teilnehmer und in Präsenz ab 3 Teilnehmer führen wir ein Seminar durch, so dass Sie auch bei kleinerer Gruppengröße intensiv lernen können und Ihren Lernerfolg erzielen können.

Sollten Sie in einem mehrtägigen Seminar bis zum Ende des ersten Seminartags merken, dass dieses Seminar nicht Ihren Erwartungen entspricht, sprechen Sie bitte mit dem Kursleiter am ersten Seminartag und es wird Ihnen die volle Kursgebühr inkl. Anreise (30 cent / km bzw. Bahnfahrt 2. Klasse) erstattet. Ohne Wenn und Aber.

Falls Ihr(e) MitarbeiterIn unerwarteterweise innerhalb eines halben Jahres nach dem Besuchen eines Kurses für mehr als 6 Monate (Krankheit, Elternzeit, Sabbatical,...) ihr Unternehmen verlässt, darf kostenlos ein Kollege innerhalb eines Jahres ab dem Verlassen des Kollegens ein stattfindendes Seminar mit demselben Inhalt besuchen.

Die Kurse sind hands-on Trainings, mit vielen Coding Übungen (inkl. digitalen Musterlösungen). Denn durch praktische Beispiele lernt man am meisten.

Wenn es im Interessen der Schulungsgruppe ist, ändert der Trainer das Seminar nach Ihren Wünschen ab bzw. integriert Ihre Daten nach Rücksprache in den Kurs.

Sollten Sie eine Schulung zweimal besuchen, wird diese nicht identisch sein. Ihr Feedback wird berücksichtigt und die Schulungen werden an die aktuelle Themen in Forschung und Entwicklung angepasst.

Die Trainer, die in exklusiver Kooperation mit Enable AI zusammen arbeiten, kommen alle aus der Praxis und vermitteln praxisnahes, aktuelles Wissen auf leicht verständliche Art und Weise mit dem Ziel, dass Sie in Ihrer Arbeit das Wissen direkt anwenden können.

Garantierte maximale Gruppengröße von 10 Teilnehmern. Im Durchschnitt besuchen 3-6 Teilnehmer einen Kurs.

Vor der Zusammenarbeit werden unsere Trainer geprüft. Alle besitzen fundierte Kenntnisse, u.a. durch Studium, Promotion und Berufserfahrung in den Bereichen Mathematik, Informatik, Statistik und Machine/Deep Learning.

Dr. Kaya Kupferschmidt

Nach seinem Mathematikstudium promovierte sich Dr. Kaya Kupferschmidt an der Universität Frankfurt im Jahr 2004 im Bereich Stochastik. Während seines Studiums arbeitete er am Fraunhofer Institut für grafische Datenverarbeitung in Darmstadt und als Spieleentwickler bei Neon Studios in Frankfurt.

2005 gründete er dimajix, wo er als Trainer und Berater mit Schwerpunkt Big Data / Apache Spark im Hadoop-Ökosystem fungiert. Daneben verfügt er über profunde Erfahrung u.a. in den Bereichen Data Science, Effiziente Algorithmen und Machine Learning.

Als Berater hat er u.a. Daten-Projekte in der Energiewirtschaft und in der Online-Werbung bearbeitet. Zudem hat er Erfahrung in der effizienten Bearbeitung von unternehmensweiten Data Lakes in großen Finanzinstituten.

- Fragen zum Inhalt des Seminars?

- Sind Sie sich unsicher, ob der Kurs Sie weder über- noch unterfordert?

- Fragen, ob Sie das Wissen aus dem Kurs für Ihre tägliche Arbeit anwenden können?

- weitere generelle Fragen zur Schulung?

- einen Terminwunsch?

Rufen Sie uns an oder schreiben Sie uns eine Email

0711-96 88 15 53

info@enable-ai.de

Gerne können Sie auch direkt einen Termin mit uns vereinbaren oder eine Nachricht schreiben.

Inhouseschulung / Firmenschulung

Sie suchen einen Big Data Intensivkurs als Firmen-Weiterbildung. Der Inhalt der Schulung kann individuell angepasst werden. In Abstimmung mit dem Dozenten können Sie Schwerpunkte der Firmen-Schulung setzen, Inhalte aus der offenen Schulung streichen und weitere Inhalte hinzufügen.

Vereinbaren Sie einen Termin für ein kostenloses Beratungsgespräch.

Die Firmen-Trainings des PySpark Big Data Kurses können Live-Online oder bei Ihnen vor Ort gehalten werden. Zudem können Sie auch in München, Stuttgart, Berlin, Hannover, Köln, Hamburg, Düsseldorf, Frankfurt, Dortmund, Münster, Essen, Bonn, Dresden, Leipzig, Bremen, Duisburg, Bochum, Wuppertal, Bielefeld, Mannheim, Freiburg, Brauschweig, Kiel oder Karlsruhe stattfinden.

Schulungen

In dieser Schulung lernen Sie, wie Sie schnell und effektiv Ihre Daten und Ergebnisse mit Python visualisieren und mit anderen teilen können. Auch die interaktive Visualisierung wird behandelt. Verwendete Python Pakete sind: pandas, matplotlib, plotly, rise, ipywidgets, voila, streamlit.

Big Data in Excel: Der Schwerpunkt des Seminars liegt in der Aufbereitung und Verknüpfung unterschiedlicher Tabellen oder – allgemein gesprochen: wie kann man (große) Datenmengen aus unterschiedlichen Quellen verarbeiten? Ziel ist es mit Hilfe des Datenmodells komplexe Auswertungen vereinfacht durchzuführen.

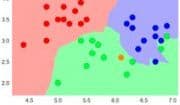

Aufbauend auf Python Grundkenntnissen, werden supervised und unsupervised Machine Learning Algorithmen in scikit-learn und die wichtigsten Schritte beim Trainieren der Algorithmen behandelt. Folgende Algorithmen werden erläutert: Lineare & Logistische Regression, Entscheidungsbaum, Ensembles, Neuronales Netz (MLP), K-Nearest Neighbor, K-means, DBSCAN Clustering.